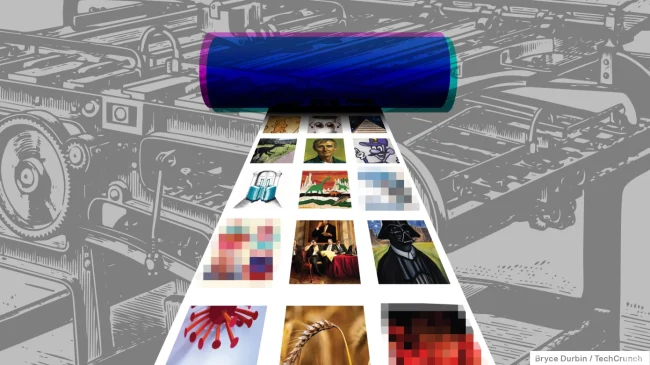

【人工智慧藝術】Stable Diffusion 產生AI圖片生成圖片(文字生成圖片)可以模型訓練!

目前非常熱門的【人工智慧藝術】Stable Diffusion 它可以使用文字生成圖片(或圖片生成圖片)

使用者還可以藉助『模型訓練』與外掛程式,讓其產生的圖片更加符合創作者所需!

藝術家們表示擔心 Stable Diffusion 等模型的廣泛使用最終可能導致人類藝術家以及攝影師、模特、電影攝影師和演員逐漸失去與基於人工智慧的競爭對手的商業可行性。

那我們來研究一下,究竟Stable Diffusion 等模型是怎樣的AI【人工智慧藝術圖片】產生器?

Stable Diffusion web UI 是基於 Gradio 的瀏覽器界面,用於 Stable Diffusion 模型的各種應用。

如:文生圖、圖生圖等,適用所有以 Stable Diffusion 延伸的擴充模型。

「Dreambooth Extension」,這是一個可以讓您在不離開 web UI 的情況下自行訓練 ckpt 大型模型的擴充,DreamBooth 是指一種客製化文生圖模型的方法,可以給特定主題或風格的幾張影像來實現穩定擴散。

另外由於訓練大型模型非常吃實體硬體資源,因此該擴充也進行了優化,只要做好設定就能在較低 VRAM 的 GPU 上正常跑訓練

(不然可能會吃掉 2X GB 以上,極少數人才擁有這樣瘋狂的設備!),當然建議起碼要有 10 GB 以上的 VRAM 再來訓練。

Stable Diffusion web UI 官方網站:

https://github.com/AUTOMATIC1111/stable-diffusion-webui

Dreambooth Extension 官方網站:

https://github.com/d8ahazard/sd_dreambooth_extension

Stable Diffusion是2022年發布的深度學習文字到圖像生成模型。

它主要用於根據文字的描述產生詳細圖像,儘管它也可以應用於其他任務,如內補繪製、外補繪製,以及在提示詞指導下產生圖生圖的翻譯。

它是一種潛在變數模型的擴散模型,由慕尼黑大學的CompVis研究團體開發的各種生成性類神經網路。

它是由初創公司StabilityAI、CompVis與Runway合作開發,並得到EleutherAI和LAION(英語)的支援。

截至2022年10月,StabilityAI籌集了1.01億美元的資金。

Stable Diffusion的代碼和模型權重已公開發布,可以在大多數配備有適度GPU的電腦硬體上運行。

而以前的專有文生圖模型(如DALL-E和Midjourney)只能通過雲端運算服務訪問。

Stable Diffusion模型支援通過使用提示詞來產生新的圖像,描述要包含或省略的元素,以及重新繪製現有的圖像,其中包含提示詞中描述的新元素(該過程通常被稱為「指導性圖像合成」

(guided image synthesis))通過使用模型的擴散去噪機制(diffusion-denoising mechanism)。

此外,該模型還允許通過提示詞在現有的圖中進行內補繪製和外補繪製來部分更改,當與支援這種功能的使用者介面使用時,其中存在許多不同的開源軟體。

Stable Diffusion建議在10GB以上的VRAM下運行, 但是VRAM較少的使用者可以選擇以float16的精度載入權重,而不是默認的float32,以降低VRAM使用率。

Stable Diffusion 使用文字生圖片:

Stable Diffusion中的文生圖採樣指令碼,稱為”txt2img”,接受一個提示詞,以及包括採樣器(sampling type),圖像尺寸,和隨機種子(粵語)的各種選項參數,並根據模型對提示的解釋生成一個圖像檔案。

生成的圖像帶有不可見的數位浮水印標籤,以允許使用者識別由Stable Diffusion生成的圖像,[5]儘管如果圖像被調整大小或旋轉,該浮水印將失去其有效性。

Stable Diffusion模型是在由512×512解析度圖像組成的數據集上訓練出來的,這意味著txt2img生成圖像的最佳組態也是以512×512的解析度生成的,偏離這個大小會導致生成輸出品質差。

Stable Diffusion 2.0版本後來引入了以768×768解析度圖像生成的能力。

每一個txt2img的生成過程都會涉及到一個影響到生成圖像的隨機種子;使用者可以選擇隨機化種子以探索不同生成結果,或者使用相同的種子來獲得與之前生成的圖像相同的結果。

使用者還可以調整採樣迭代步數(inference steps);較高的值需要較長的運行時間,但較小的值可能會導致視覺缺陷。

另一個可組態的選項,即無分類指導比例值,允許使用者調整提示詞的相關性(classifier-free guidance scale value);更具實驗性或創造性的用例可以選擇較低的值,而旨在獲得更具體輸出的用例可以使用較高的值。

反向提示詞(negative prompt)是包含在Stable Diffusion的一些使用者介面軟體中的一個功能

(包括StabilityAI自己的「Dreamstudio」雲端軟體即服務模式訂閱制服務),它允許使用者指定模型在圖像生成過程中應該避免的提示,適用於由於使用者提供的普通提示詞,或者由於模型最初的訓練,造成圖像輸出中出現不良的圖像特徵,例如畸形手腳。

與使用強調符(emphasis marker)相比,使用反向提示詞在降低生成不良的圖像的頻率方面具有高度統計顯著的效果;

強調符是另一種為提示的部分增加權重的方法,被一些Stable Diffusion的開源實現所利用,在關鍵詞中加入括號以增加或減少強調。

Stable Diffusion 使用圖片產生圖片:

Stable Diffusion包括另一個取樣指令碼,稱為”img2img”,它接受一個提示詞、現有圖像的檔案路徑和0.0到1.0之間的去噪強度,並在原始圖像的基礎上產生一個新的圖像,該圖像也具有提示詞中提供的元素;

去噪強度表示添加到輸出圖像的噪聲量,值越大,圖像變化越多,但在語義上可能與提供的提示不一致。

圖像升頻是img2img的一個潛在用例,除此之外。

2022年11月24日發布的Stable Diffusion 2.0版本包含一個深度引導模型,稱為”depth2img”,該模型推斷所提供的輸入圖像的深度(英語),並根據提示詞和深度資訊生成新圖像,在新圖像中保持原始圖像的連貫性和深度。

Stable Diffusion 內補繪製與外補繪製:

Stable Diffusion模型的許多不同使用者介面軟體提供了通過img2img進行圖生圖的其他用例。

內補繪製(inpainting)由使用者提供的蒙版(英語)描繪的現有圖像的一部分,根據所提供的提示詞,用新生成的內容填充蒙版的空間。

隨著Stable Diffusion 2.0版本的發布,StabilityAI同時建立了一個專門針對內補繪製用例的專用模型。

相反,外補繪製(outpainting)將圖像擴展到其原始尺寸之外,用根據所提供的提示詞生成的內容來填補以前的空白空間。

Stable Diffusion 的模型訓練:

Stable Diffusion是在LAION-5B的圖片和標題對上訓練的,LAION-5B是一個公開的數據集,源自從網路上抓取的Common Crawl(英語)數據。

該數據集由LAION(英語)建立,LAION是一家德國非營利組織,接受StabilityAI的資助。

該模型最初是在LAION-5B的一個大子集上訓練的,最後幾輪訓練是在「LAION-Aesthetics v2 5+」上進行的,這是一個由6億張帶標題的圖片組成的子集,人工智慧預測人類在被要求對這些圖片的喜歡程度打分時至少會給5/10打分。

這個最終的子集也排除了低解析度的圖像和被人工智慧識別為帶有浮水印的圖像。

對該模型的訓練數據進行的第三方分析發現,在從所使用的原始更廣泛的數據集中抽取的1200萬張圖片的較小子集中,大約47%的圖像樣本量來自100個不同的網站,其中Pinterest佔8.5%子集

其次是WordPress,Blogspot,Flickr,DeviantArt和維基共享資源等網站。

該模型是在亞馬遜雲計算服務上使用256個NVIDIA A100 GPU訓練,共花費15萬個GPU小時,成本為60萬美元。

Stable Diffusion 的終端使用者微調訓練:

為了糾正模型初始訓練的局限性,終端使用者可以選擇實施額外的訓練,以微調生成輸出以匹配更具體的使用情況。有三種方法可以讓使用者對Stable Diffusion模型權重存檔點進行微調:

「嵌入」(Embedding)可以從使用者提供的一些圖像被訓練出來,並允許模型在提示詞中使用嵌入的名稱時生成視覺上相似的圖像。

嵌入是基於2022年臺拉維夫大學的研究人員在英偉達的支援下開發的「文字倒置」(Textual Inversion)概念,其中模型的文字編碼器使用的特定標記的向量表示與新的偽詞相關聯。

嵌入可以用來減少原始模型中的偏差,或模仿風格。

「超網路」(Hypernetwork)是NovelAI軟體開發員Kurumuz在2021年創造的一種技術

最初用於調節文字生成的Transformer模型,它能讓Stable Diffusion衍生的文生圖模型模仿各種特定藝術家的風格,無論原始模型能否識別此藝術家,通過在較大的神經網路中的不同點應用一個預訓練的小神經網路。

超網路將文生圖或圖生圖結果導向特定方向,例如加上藝術風格,當與一個較大的神經網路結合使用時。它通過尋找重要的關鍵區域來處理圖像(例:眼睛,頭髮),然後在二級潛在空間中修補這些區域。

超網路的一個缺點是它們的準確性相對較低,也有時會產生不可預知的結果。因此,超網路適用於加上視覺風格或清理人體瑕疵。

DreamBooth是一個深度學習模型,由Google Research和波士頓大學的研究人員於2022年開發,可以微調模型以產生與指定主題相關的輸出圖像。